分割的多头注意力机制

论文通过添加一种称为“多头”注意力的机制进一步细化了自注意力。它扩展了模型关注不同位置的能力。

比如对于以下语句:“The animal didn’t cross the street because it was too tired”

在语义不同的时候,可以有不同的注意力,比如“it”关注于指代的东西时候,对“animal”有很高的权重;“it”关注于其当前形容词的时候,对“tired”有很高的权重。

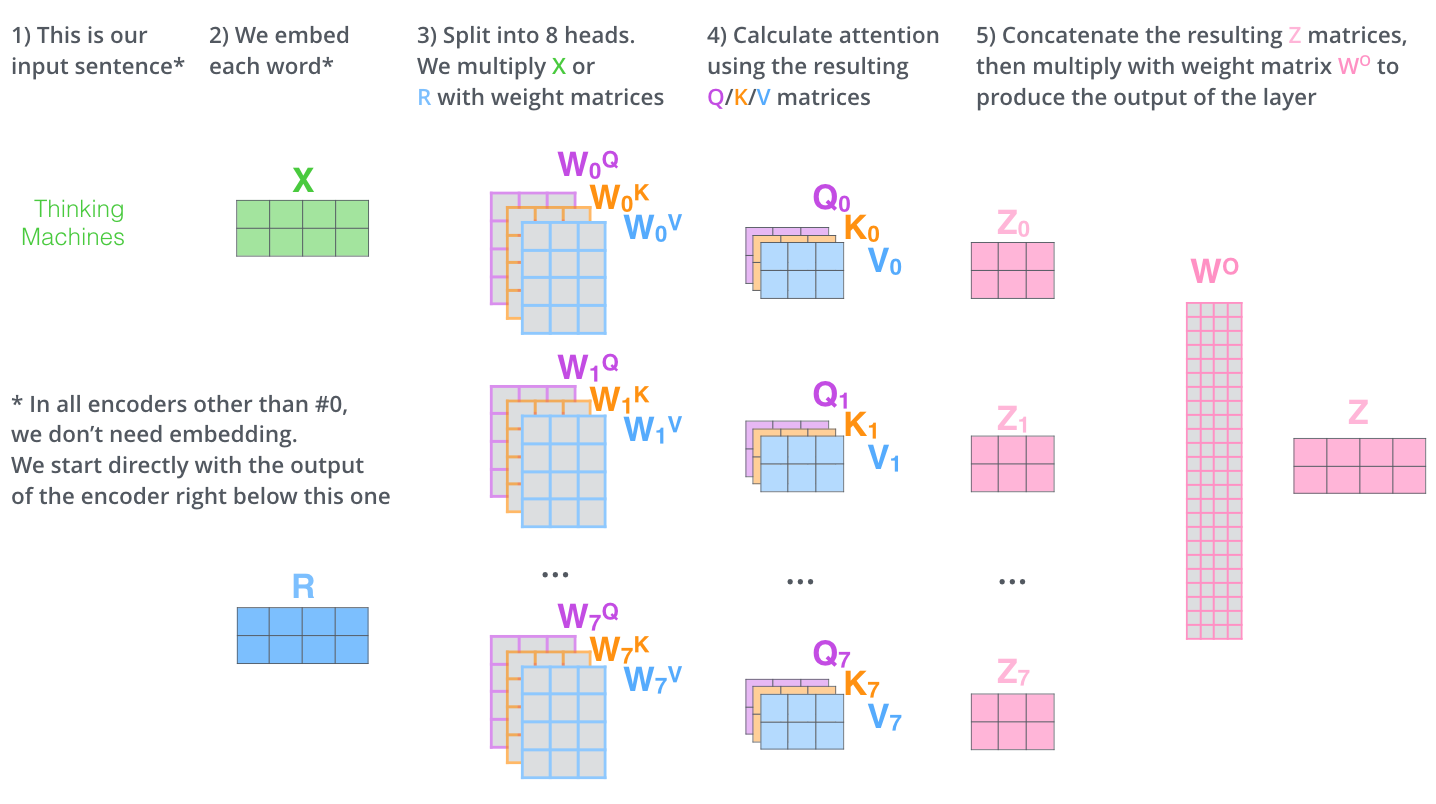

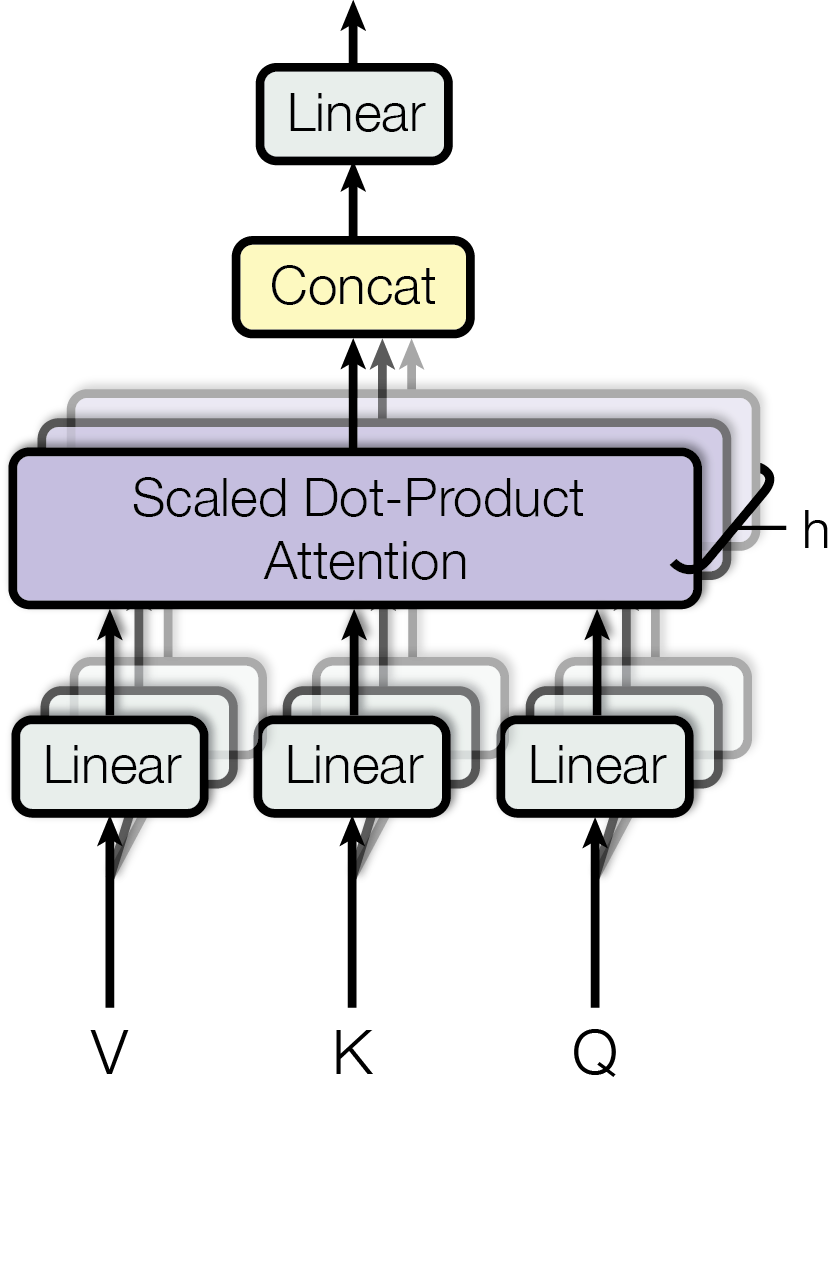

如下图所示,原始论文中使用了 8 个注意力头,每个注意力头都有自己的 / / 矩阵。

这可以理解为有 8 个不同的特征子空间,每个子空间可以提取不同的特征表示,最终嵌入 (投影) 到同一个向量中。

对于这个合成的嵌入向量再做一次矩阵变换,得到最终的注意力矩阵 。